🎨步骤三:探索性分析(EDA)

1️⃣ 描述性统计:计算均值、方差、分位数,快速掌握数据分布311。

2️⃣ 可视化洞察:

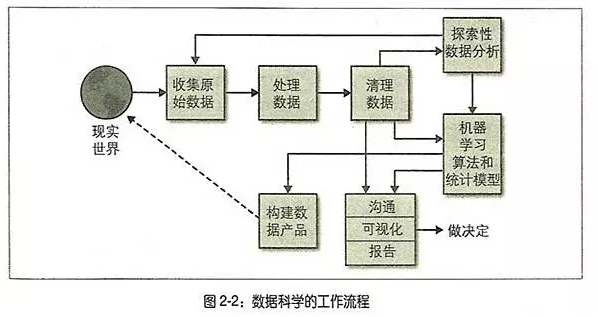

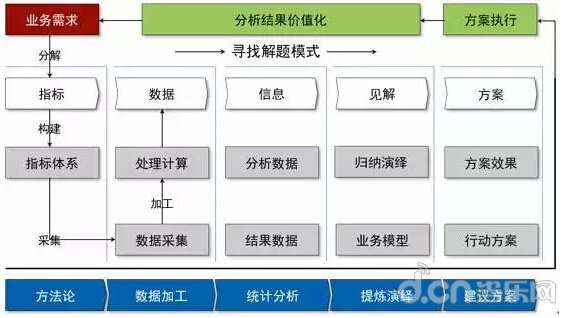

🔍步骤一:锁定问题核心

1️⃣ 目标拆解:先明确分析目的!

比如电商团队想提升GMV,需拆解为“用户复购率低”或“新客转化差”等具体问题,避免大海捞针式分析45。

2️⃣ 业务对齐:与需求方深度沟通,确认数据范围和分析维度,避免“做无用功”8。

3️⃣ 场景模拟:设想可能的影响因素,如“促销活动设计”或“用户画像偏差”,为后续数据采集铺路5。

🚀步骤五:结果落地与迭代

1️⃣ 报告输出:

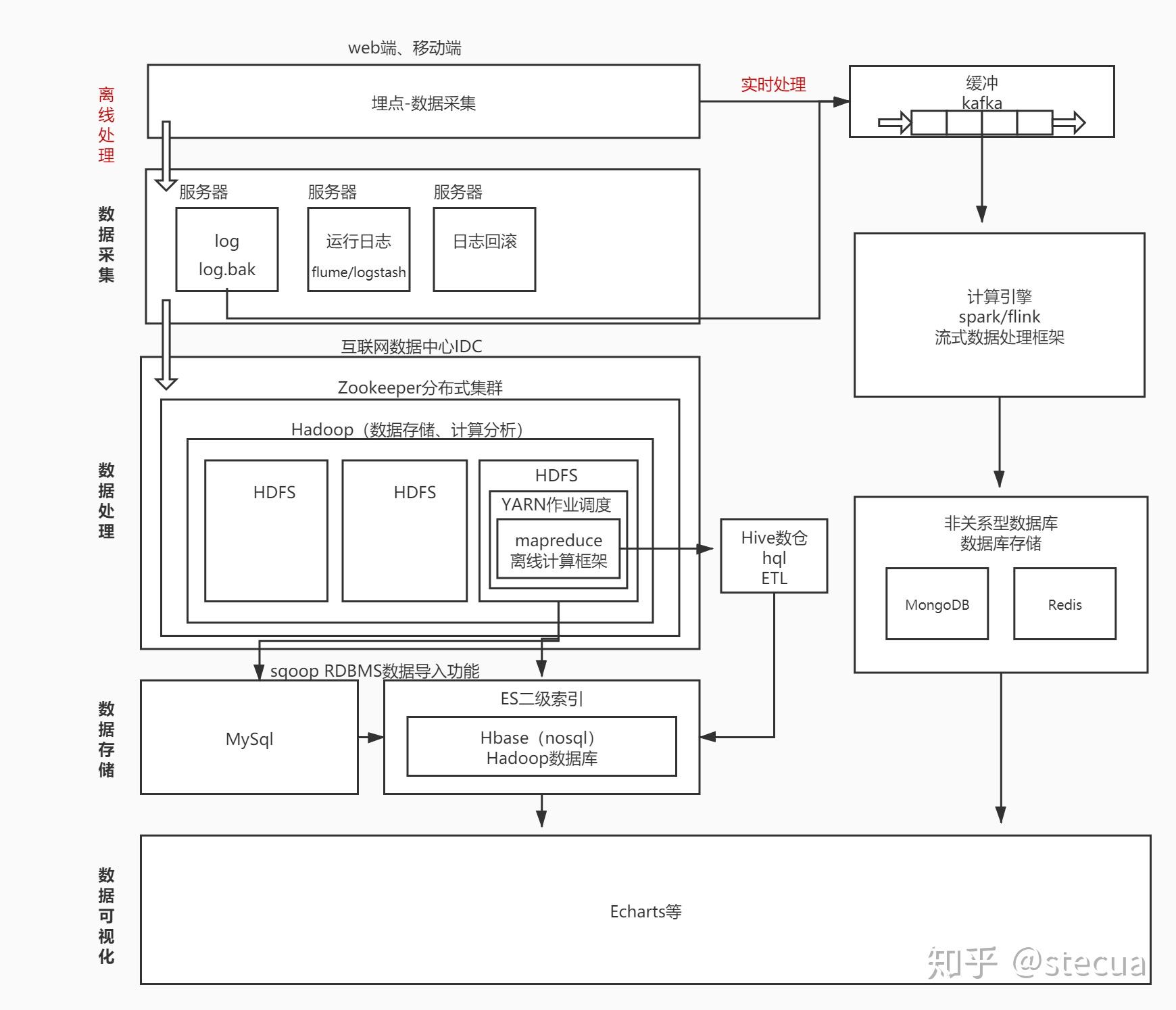

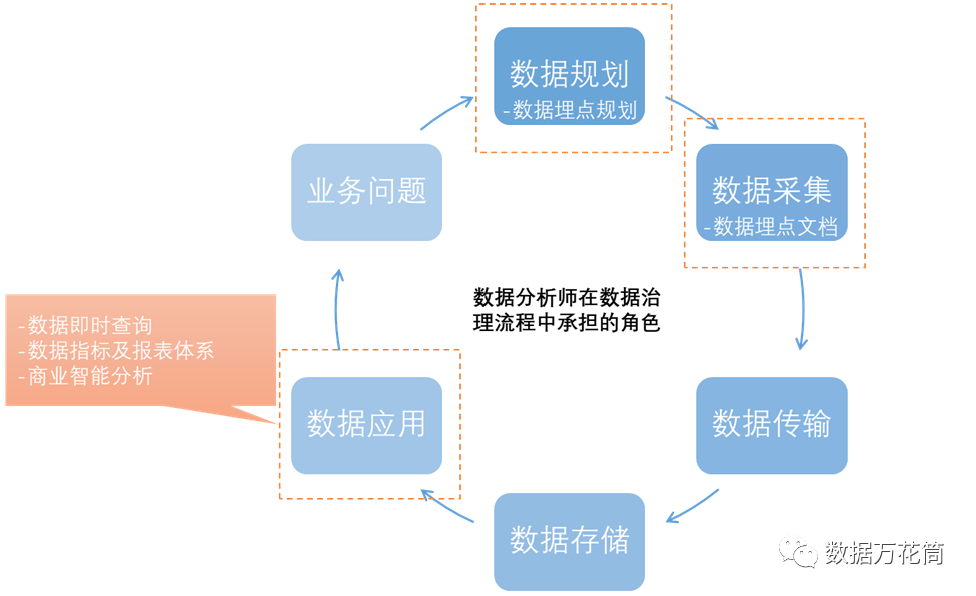

🛠️步骤二:数据采集与清洗

1️⃣ 多源抓取:

🤖步骤四:建模与优化

1️⃣ 模型选择:

- @数据小能手:步骤拆解太详细了!尤其是EDA部分,直接拯救了我的月度报告~

- @分析小白:原来建模前还要做这么多预处理!终于知道为啥以前结果不准了😭

- @职场新人:跟着流程走了一遍,老板夸我“逻辑清晰”,升职加薪有望了✨

- @创业狗:数据驱动决策YYDS!用这个框架优化了投放策略,ROI翻倍!

- @斜杠青年:案例接地气,适合跨界学习的打工人,已收藏反复看!

Tips:用思维导图梳理问题,逻辑更清晰!🗺️

数据分析不仅是技术活,更是一场逻辑与创意的碰撞!💡今天带大家拆解完整流程,从「问题定义」到「结果落地」,每一步都藏着超多实用技巧~

- 内部数据(SQL调取、企业数据库)

- 外部数据(爬虫抓取公开信息、API接口调用)59。

2️⃣ 数据预处理: - 清洗脏数据:用Pandas处理缺失值(

fillna())、异常值(箱线图法)、重复值(drop_duplicates())610。 - 格式转换:日期标准化、文本转数值(如“男/女”→1/0)36。

3️⃣ 存储优化:将清洗后的数据保存为CSV或数据库表,方便后续调用6。

举个栗子🌰:分析用户留存时,需合并“登录日志”和“消费记录”,确保数据关联性!

- 用Matplotlib绘制趋势图,发现“周末销量突增”规律📈

- 用Seaborn热力图分析变量相关性(如“广告投入”与“销售额”强相关)69。

3️⃣ 假设验证:通过统计检验(如T检验、卡方检验)验证业务猜想,比如“新功能是否提升了留存?”310。

避坑指南❗:警惕“幸存者偏差”!比如分析用户评价时,需排除“沉默用户”的影响。

- 用PPT/BI工具制作动态看板,突出“关键”和“行动建议”📊

- 附加数据附录,供技术团队复现分析811。

2️⃣ 业务反馈:跟踪策略执行效果,比如“优化商品推荐算法后,CTR提升15%”💪

3️⃣ 模型监控:设置自动化预警(如“预测误差率>10%时触发报警”)7。

💬网友热评:

- 预测类问题→线性回归、随机森林

- 分类问题→逻辑回归、XGBoost69。

2️⃣ 特征工程: - 构造衍生变量(如“用户活跃天数/总天数”→活跃度指标)

- 降维处理(PCA减少冗余特征)610。

3️⃣ 调参优化:用网格搜索(GridSearchCV)找最佳超参数,提升模型AUC值6。

案例分享:某零售品牌通过聚类模型,将用户分为“价格敏感型”和“品质导向型”,实现精准营销🎯

📊数据分析的流程和步骤全解析 | 新手必看宝藏指南

相关问答

文章来源:

用户投稿

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。